robots.txt(ロボッツテキスト)は、検索エンジンが最初読むファイルです。

設置しなくても問題ありませんが、10000ページを超えるような大規模なサイトではクローラの制御のために設置した方が良いでしょう。

また、設定方法が間違っていることで全くインデックスされないという事態も起こり得ます。

この記事では、SEO初心者のためにrobots.txtの役割やチェック方法などについてまとめました。

robot.txtに関するGoogleの公式ドキュメントはこちらです。

robots.txt ファイルを作成して送信する | Google 検索セントラル | Google Developers

目次

robots.txtの役割は2つ

robots.txtの役割は、

- クローラー(検索エンジン)の制御

- クローラーにsitemap.xmlの場所を教える

の2つがあります。

クローラー(検索エンジン)の制御

インデックスさせたくないページをクローラーが巡回しないように設定できます。

大規模ECサイトでは自動生成ページが10000ページを超える場合もあり、すべてのページをクローラに巡回させるのは非効率です。

一般的なサイトでは必要ありませんが、大規模サイトでは効率的なクローラの巡回のために有効な設定です。

sitemap.xmlの場所を教える

robots.txtは検索エンジンが最初に読むファイルです。

sitemap.xmlのファイルの場所を記載することで、サイト全体の構造をクローラーが素早く把握することができます。

設置しなくても問題ない

robots.txtは、設置していなくても問題ありません。

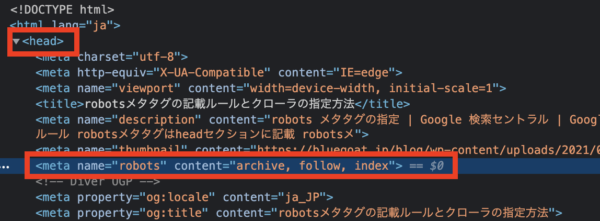

robots.txtが設置されていないサイトはHTML内のrobotsメタタグがクロールされるので、問題なくインデックスされます。

設置するだけで順位が上がるものでもないので、クロールの制御を行う必要のないサイトでは無理に設置する必要はありません。

むしろ、記述を間違えるとサイトがインデックスされないリスクがあります(後述)

SEO効果はほとんどない

設置していた方が少しだけインデックスが早くなりますが、設置していなくてもGoogleサーチコンソールなどでxmlサイトマップを送信すれば同様の効果があります。

とはいえ、XMLサイトマップの送信ができない検索エンジンも存在するため、robots.txtを設置する際はサイトマップも記載しておきましょう。

robots.txtの設置チェック方法

robots.txtの設置チェック方法は

- URLを直接打ち込む

- サーチコンソールでチェックする

- テストツールを使う

の3つの方法があります。

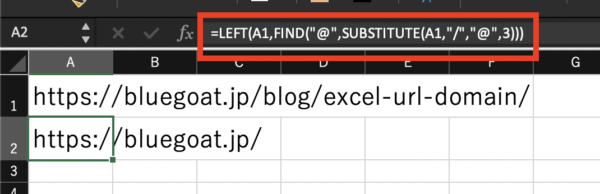

URLを打ち込んでチェック

robots.txtの保存場所は、基本的にサイトのルート直下に設置されています。

なので、"https://ドメイン名/robots.txt"でURLを打ち込むと、設置されている場合はファイルの内容が表示されます。

なお、当サイトの場合はこのように表示されます。

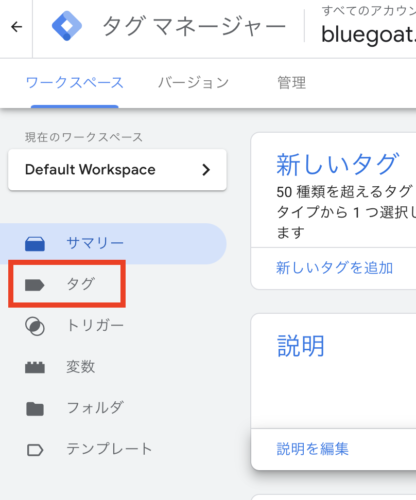

サーチコンソールで調べる方法

設定>クロールの統計情報>ホストのステータス>robots.txt の取得

から、robots.txtの設置を調べることができます。

テストツールを使う

旧サーチコンソールのRobots.txtテストツールを使うことで、robots.txtが設置されているかどうかすぐに調べることができます。

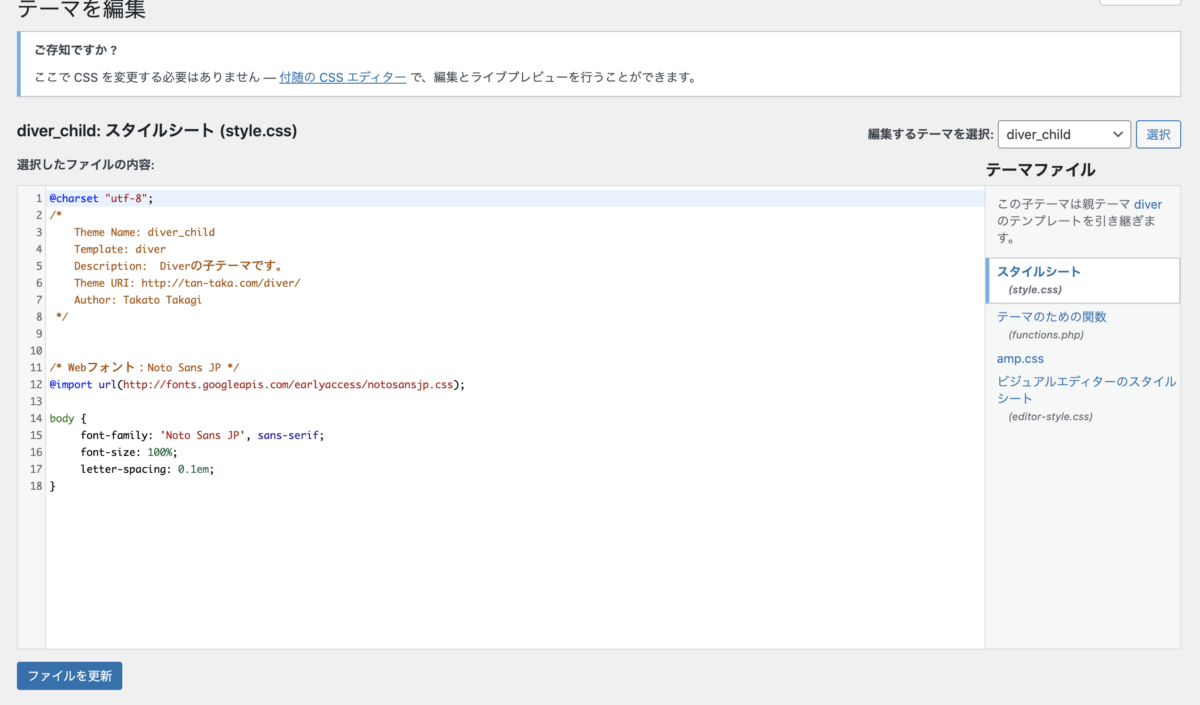

WordPressの場合は自動生成される

WordPress ではrobots.txt はアクセスがあった場合のみ自動生成される仕組みになっています。

実体がないので「仮想 robots.txt」と呼ばれており、サーバー内にファイルを確認することはできません。

robots.txtの作り方

robots.txtの記述例

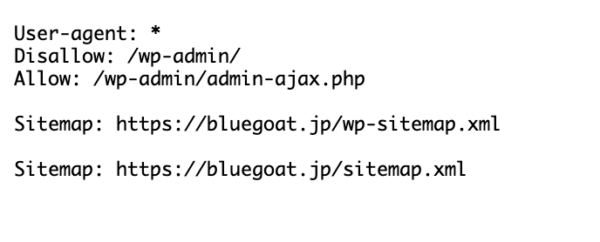

当サイトのrobots.txtの記述はこのような内容です。

User-agent: *

Disallow: /wp-admin/

Allow: /wp-admin/admin-ajax.php

Sitemap: https://bluegoat.jp/wp-sitemap.xml

Sitemap: https://bluegoat.jp/sitemap.xmlログイン用のwp-adminページなどは、インデックスする必要がないのでDisallowでクロールされないようになっています。

エディタとファイル形式

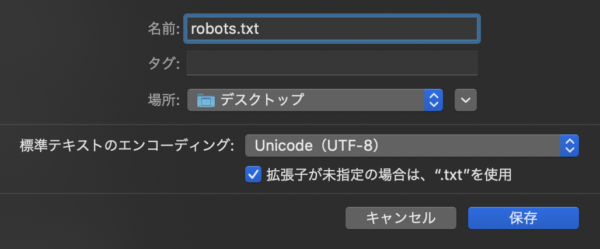

robots.txtファイルは、テキストエディタを使用して作成します。

ファイル形式は、UTF-8でエンコードされた書式なしテキストです。

UTF-8でテキストファイルが作成できるテキストエディタを使用する必要があり、macの「テキストエディット」やWindowsの「メモ帳」で作成できます。

保存する際は、エンコーディングがUTF-8になっているか確認しましょう。

ファイル名の決まり

「robots.txt」でなければいけません。「ROBOTS.TXT」など大文字もNGです。

最大ファイルサイズは512KB

robots.txtの最大ファイルサイズは、Googleでは、512KBのサイズ制限があります。

最大ファイルサイズを超えた場合、超えた分の内容は無視されます。

保存場所はルート直下

サイトのルート直下に、ファイル転送ソフトなどを使って設置します。

なお、1サイトに設置できるrobots.txtは1つだけです。

robots.txt ファイルは、適用するウェブサイト ホストのルートに配置する必要があります。たとえば、https://www.example.com/ の下にあるすべての URL に対するクロールを制御するには、robots.txt ファイルの場所を https://www.example.com/robots.txt としなければなりません。

サブディレクトリには配置できません(例: https://example.com/pages/robots.txt)。

ウェブサイトのルートへのアクセス方法が不明な場合やアクセス権限が必要な場合は、ご利用のウェブ ホスティング サービス プロバイダにお問い合わせください。

ウェブサイトのルートにアクセスできない場合は、メタタグなど、別のブロック方法を使用してください。

サブディレクトリにワードプレスを設置している場合、ルート直下のrobots.txtを編集する必要があります。

サブディレクトリを借りるサービスの場合は別の方法を

そのため、ルート直下のrobots.txtが編集できないケースでは、他のブロック方法を検討しなければなりません。

たとえば、ペライチなどで作成したページは、https://peraichi.com/のサブディレクトリ以下にページが作成されます。

https://peraichi.com/landing_pages/view/mirii

(ペライチ公式紹介ページにて掲載されていたので引用させていただきました。)

このようなレンタルサービスの場合、サービス利用ユーザーはドメイン直下robots.txtを編集することができないので、別の方法を検討する必要があります。

(ペライチはランディングページを作るサービスなので、その必要は全くありません)

URL入力とサーチコンソールで確認

設置後は、正しくアクセスして読み込めるか、URLを打ち込んでチェックしてみましょう。

サーチコンソールでの確認も併せて行いましょう。

robots.txtの注意点

SSL化したらrobots.txtも更新する

非SSLだったサイトが、SSL化した場合に起こりやすい間違いです。

サイトがSSL化したために、サイトマップのURLが

http://sample.com/sitemap.xml

↓

https://sample.com/sitemap.xml

に変更となることがあります。

その際は、robots.txt内に記述されたsitemap.xmlの設置場所も更新をするようにしましょう。

Sitemap:http://sample.com/sitemap.xml

↓

Sitemap:https://sample.com/sitemap.xml

Disallowの外し忘れで恐ろしい話

開発段階のサイトでは、すべてのページでクローラーを受け入れない設定

User-agent: *

Disallow: /を設定している場合があります。

サイトのリリース時に設定を外し忘れてしまったのか、Disallowが設定されたまま1年が経過しているサイトがありました。

せっかく良いサイトを作っても、全く検索エンジンから評価されないことになってしまうので、恐ろしい話です。

自サイトが心配な場合は、どのページがDisallow設定されているのか確認してみてください。